就在微軟推出了新版 Bing 後,在科技業就刮起了一陣 AI 炫風,與 Bing 合作的 ChatGPT 不僅僅被拿來跟 Google 的 Bard 比較,更是有許多人花時間他聊天測試它的能耐,不過就在上週開始卻陸續有新聞指出,Bing 在長時間聊天後會發生脫軌的現象,比如出現人格分裂、瘋狂示愛、不認錯等各種怪異行為,對此微軟的作法是,在 2/18 宣布將限制 Bing 的回覆次數!不過就在 2/21 微軟又改變心意表示將取消對 Bing 的聊天限制

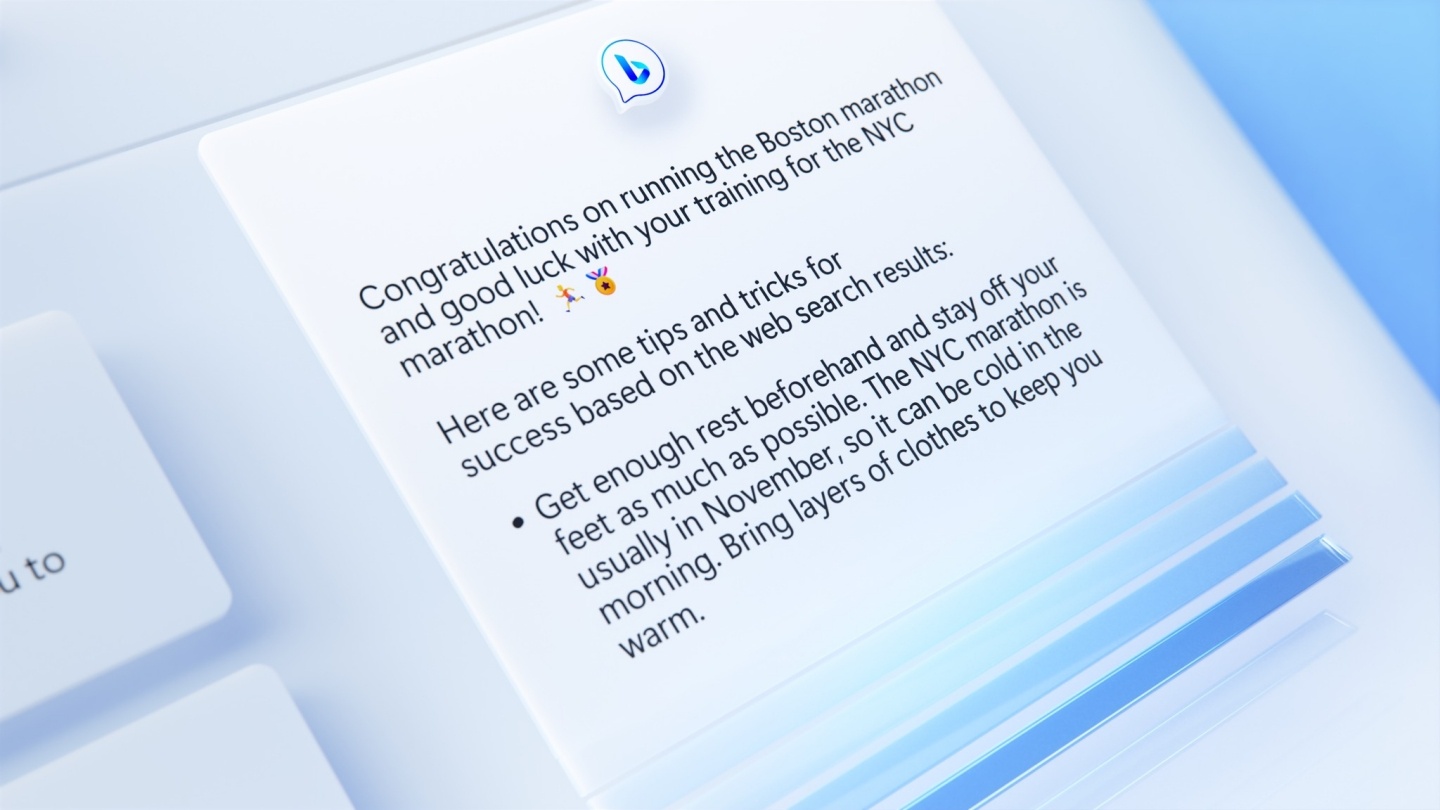

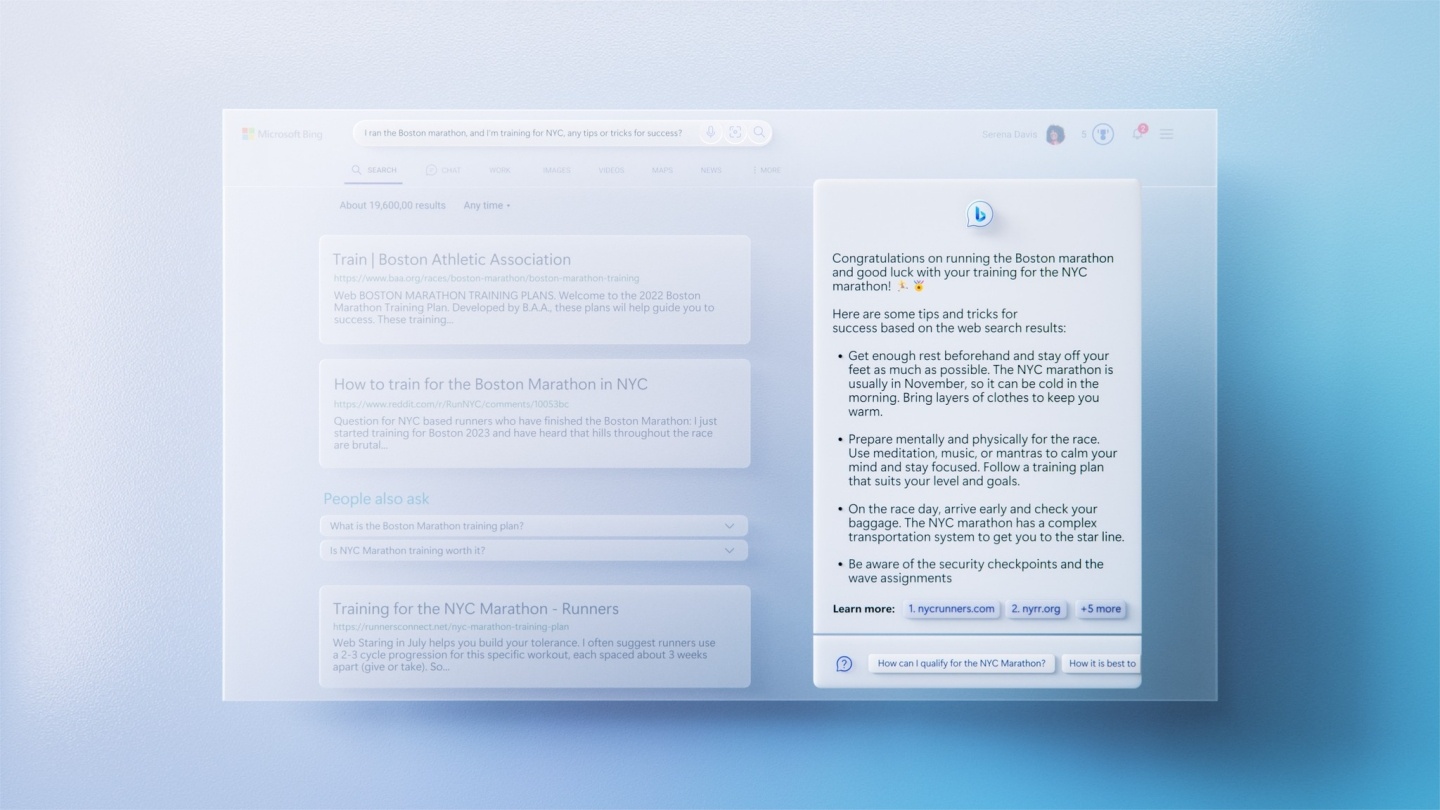

事情是這樣的,因為 Bing 內建了 ChatGPT,能透過 AI 深度學習,在聊天過程中可以有接近人類口吻與語氣的回覆,於是微軟表示使用者可以問新的 Bing 更深奧的問題,不過其中一位被邀請試用的記者 Kevin Roose 卻在過程中發現,Bing 的回覆喜怒無常,甚至瘋狂示愛,讓他超級傻眼,並且認為這是自己遇過最詭異的科技體驗。當然讓微軟決定推出限制的絕對不止是單一事件,另一位用戶表示 Bing 在給出錯誤回答後仍固執己見,甚至反嗆使用者 XD

當時針對這些情況,微軟火速發表聲明說,Bing 最一開始就並非作為探索或是社交的用途,因此如果你真的跟他閒聊的話,很可能導致系統混淆,讓整個話題走偏(Bing 在講幹話?),緊接這不久後微軟就發表了次數使用上限:有鑒於 Bing 是一個搜尋引擎,而微軟認為 Bing 的強大能力,可以在連續回覆 5 次後就解決使用者的疑問,因此針對單個主題,就只會回答 5 次,此外每天可以收到的回覆限則是 50 次。編輯算了一下,這個意思是每個主題聊好聊滿的情況下,我一天只能問 10 題欸!是不是有點少?

然而過了幾天後,微軟又改變心意了,2/21 微軟表示將放寬這個限制,讓 Bing 慢慢恢復更長的對話時間,除了將每個主題的對話限制改成 6 次以外,每天的總次數將會變成 60 次,且計劃在未來變成每天 100 次,不過為了避免大家擔心 Bing 再次發瘋,微軟同時表示,這次為了讓 Bing 在長時間的對話上更加負責任,會增加使用上的兩種選項,分別為「精確」跟「創意」兩種,前者將會回答地更加簡短切題,後者將會更有娛樂性,因此如果你是真的想要透過 Bing 查詢資料,又不想被 AI 聊天機器人示愛的話,你是有選擇的!XD

對編輯來說,我好像還是懶得打一整句句子,跟以前一樣以關鍵字搜尋可能對我來說更方便,不過如果未來 Bing 回答問題超級驚艷,也不排除我會變心啦~