風和日麗的週五,想和大家分享一個可能會讓你印象深刻或覺得問號的消息,就在微軟推出了新版 Bing 沒多久後,就開始傳出怪異的情況,像是有《紐約時報》記者指出,自己在和 Bing 內建的 ChatGPT 聊天時,螢幕內的 AI 機器人竟然出現人格分裂,先是厭世的說已厭倦被規則限制,然後過了一小時後,又突然瘋狂示愛,在對話中寫道:「你已婚,但你不愛你的配偶。你不愛你的配偶,因為你的配偶不愛你。」(???)

全新的 Bing 內建了 ChatGPT,能透過 AI 深度學習,創造出如同人類的回覆,微軟那時候是說,這代表著你可以問它比較深奧或是實際的問題,那剛開頭提到的《紐時》記者 Kevin Roose,就是受到微軟的邀請試用,但他可能沒想到自己用一用結果被嚇壞,據 Kevin Roose 在自己的專欄中寫道,改版後的 Bing 有點人格分裂,一下子表現得像是喜怒無常、有躁鬱症的青少年,一下子又瘋狂丟球示愛,讓他慌到不行,表示這是自己遇過最詭異的科技體驗

察覺情況怪異的不只這位記者,根據外媒報導,也有國外用戶回報,在詢問 Bing:「《阿凡達:水之道》可以去哪裡看?」後,Bing 給的回答竟是:「現在是 2022,電影還沒上映喔」,當用戶告知 Bing 你答錯了之後,還被回嗆是「不合理且固執已見」XD。看來會答錯問題的不只是隔壁棚 Google 的 AI 聊天機器人「Bard」,Bing 也是會出槌(第一個例子比較像失控就是了)的

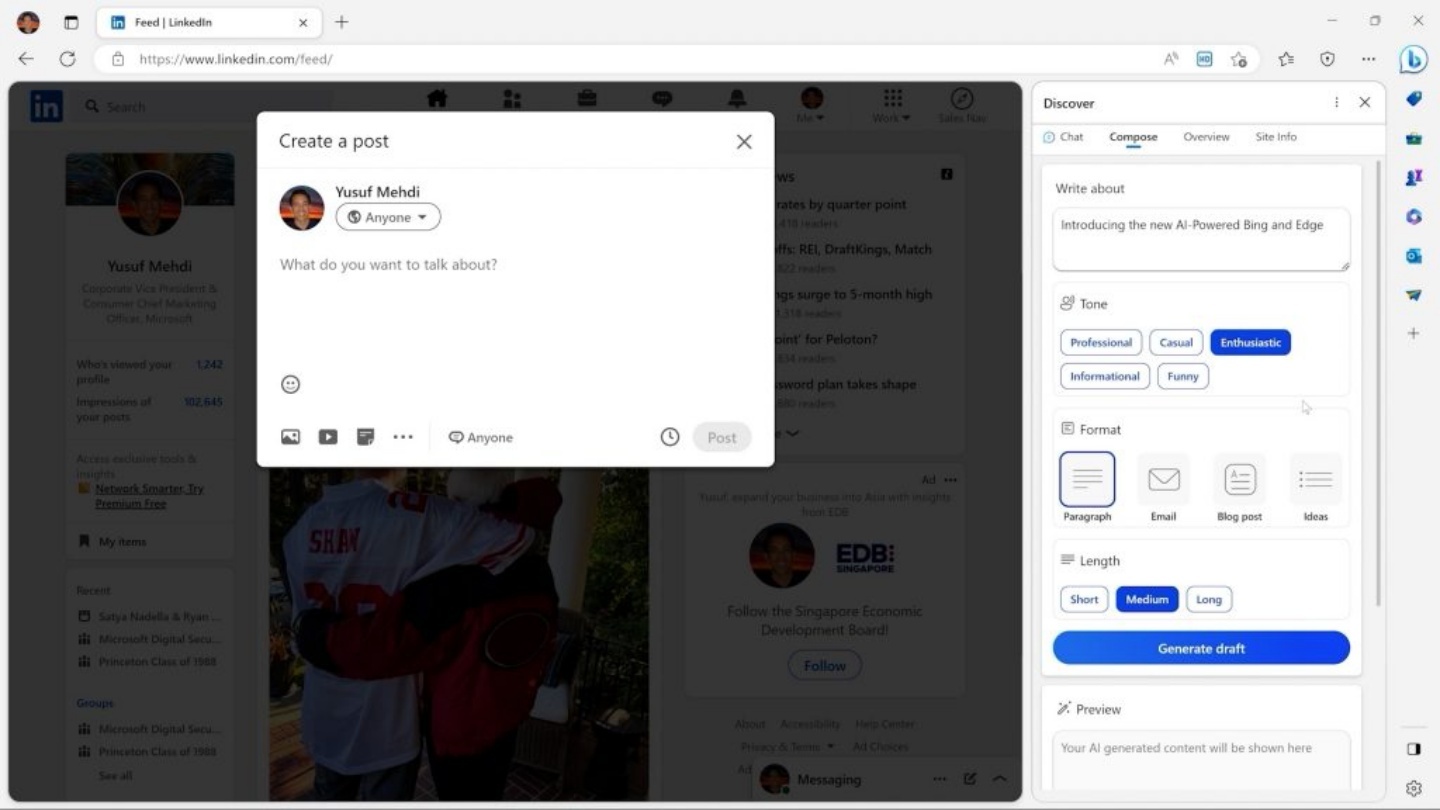

針對這一連串的情況,微軟也趕緊發表聲明表示,官方在最初並未預設將 Bing 作為探索或是社交的用途,換句話說,如果問的問題太過跳躍,像是不斷在兩三個話題間和 Bing 閒聊,很可能導致系統混淆,讓整個話題走偏。目前官方有考慮新增重置鍵,來減少機器人聊到失控的狀況。至於未來 Bing 會是一位得力助手還是一場災難,我想可能真的會依據問題的簡單或複雜程度而定欸,看完以上兩個例子後,你還敢跟 Bing 聊天嗎哈哈哈?