不知道獺友們的繪畫技巧如何,以前有沒有常常把國文課本上的人物化身各種不同的動漫角色🤣P編一直以來對畫畫就很苦手,程度大概就是畫人物只會有火柴人的支架😓現在顯卡大廠要來救救像我一樣的繪畫白癡了😳NVIDIA在今年年初推出GauGAN,一款透過AI深度學習,可以把塗鴉中的不同顏色區塊,依照它們代表的材質,創造出一張接近真實的風景照的技術。現在NVIDIA也大方地把GauGAN的Beta版本放在網路上,你也可以用超簡單色塊作畫啦!

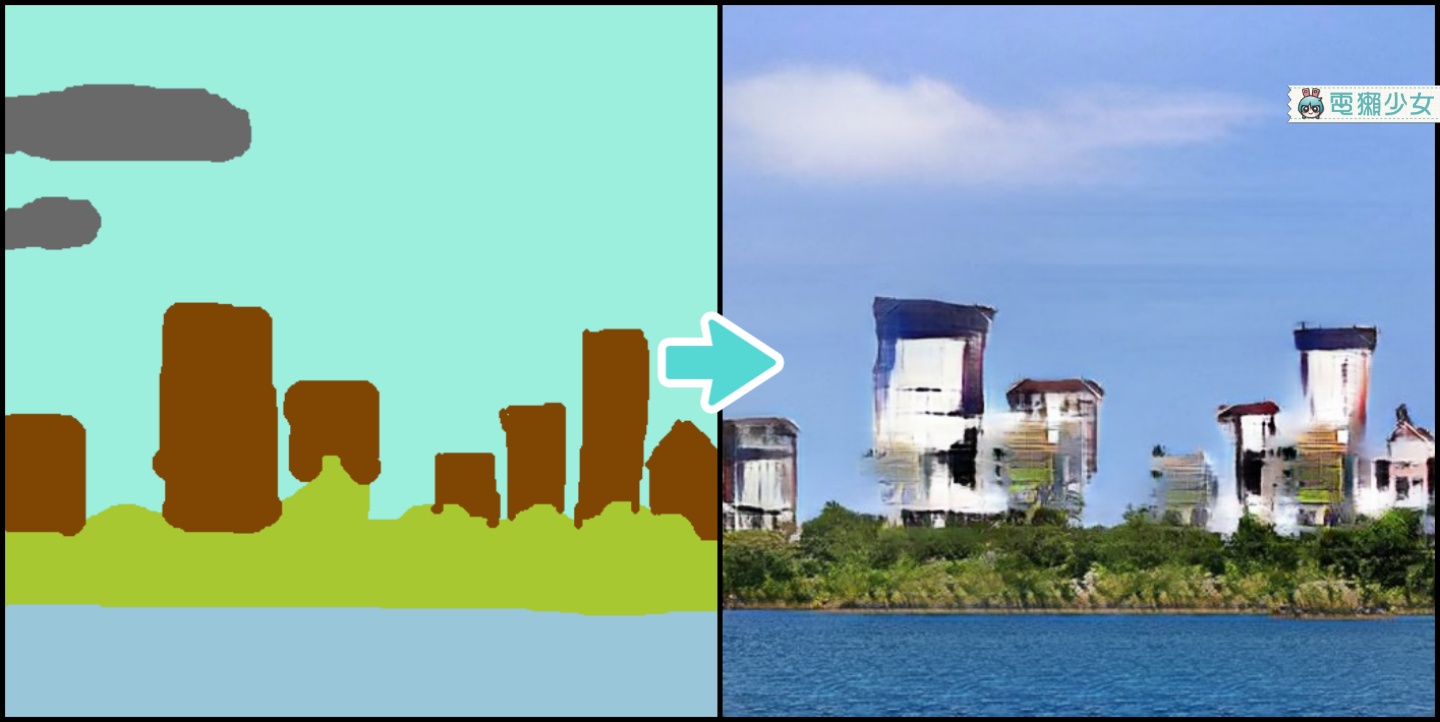

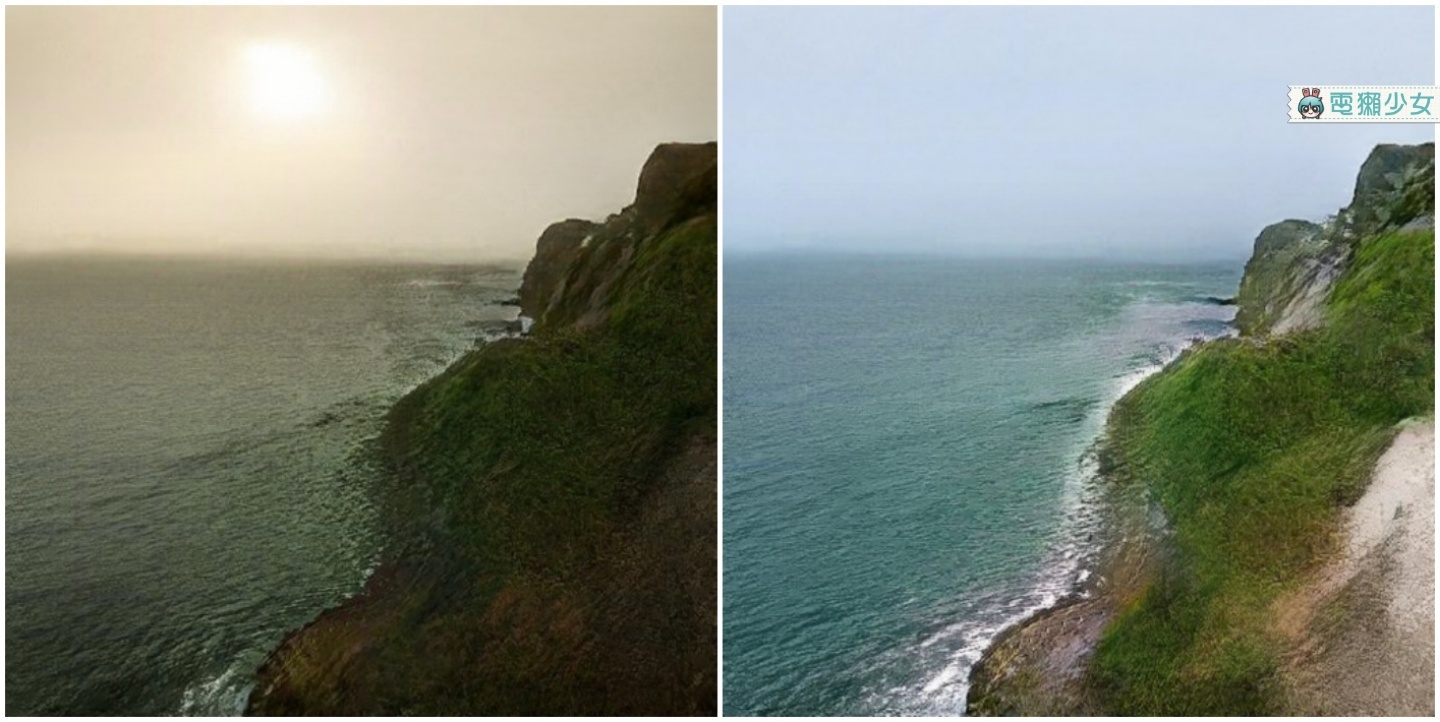

看看下面這張,左圖是P編描摹下面圖庫的風景照結構,並透過GauGAN技術產生右圖😍天哪~這個技術真的是太神奇了,完全拯救了像我這種對繪畫一竅不通的人,雖然近看的確會有破綻,但可以只利用左圖這邊一些色塊,就產生出右圖的結果,讓P編覺得AI技術瞬間離自己沒有那麼遙不可及😳

(圖片來源:Unsplash)

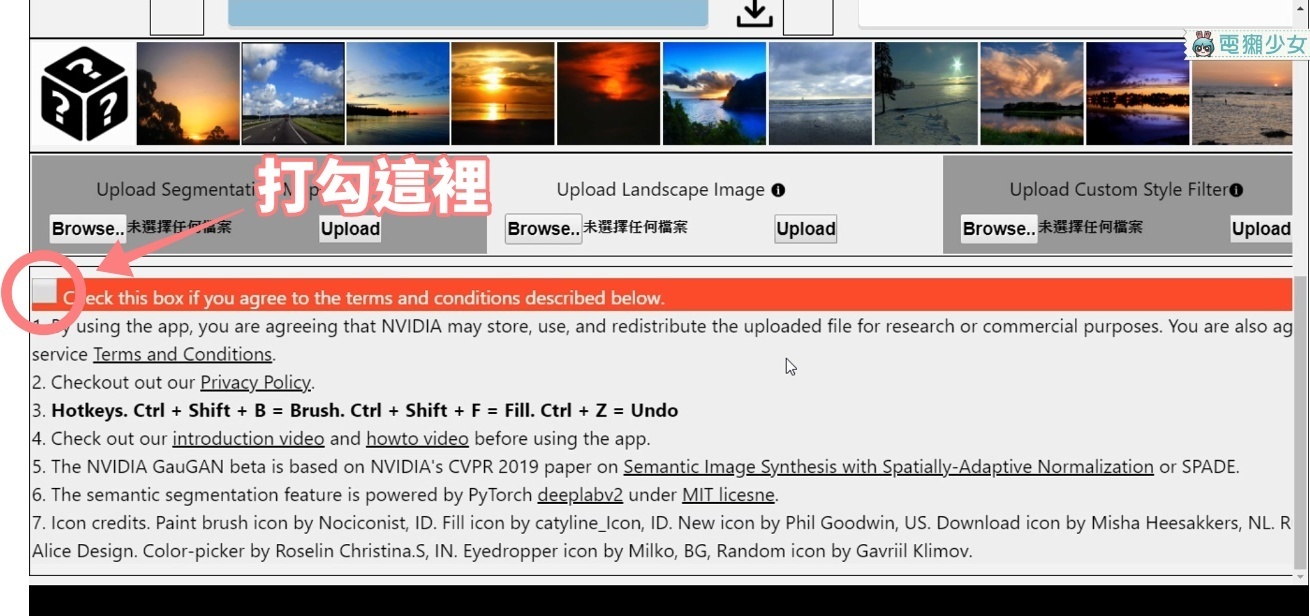

那麼要怎麼開始呢?首先先連上GauGAN Beta版網站,接著往下滾動先同意NVIDIA的使用者協議,接著就可以開始作畫啦!材質方面分成四大部分,作畫工具簡化成只有五種;作畫的方式最主要就是以筆刷圍出你想要放那個材質的範圍,之後用填色工具填滿,然後再用筆刷工具增補一下小色塊,之後再按輸出鍵就完成了!要注意的是線上使用的Beta網站,當然不會像NVIDIA示範影片一樣,可以即時運算,而是按下輸出後,一次使用雲端伺服器運算;還有返回鍵,經P編測試,好像只能返回上一個操作的內容,所以還請各位畫家們小心下筆🤣

▼同意NVIDIA的使用者協議

▼介面簡介

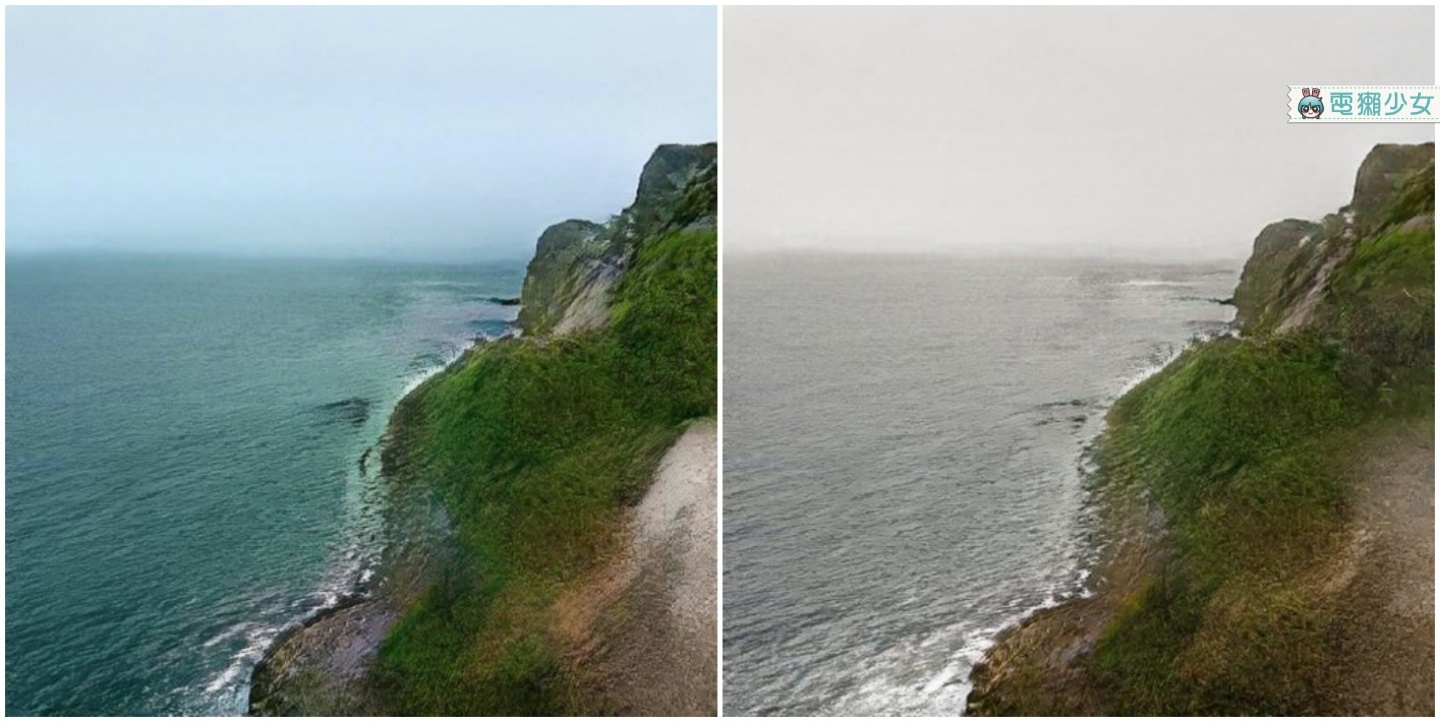

如果你的英文還不錯,可以先看看NVIDIA的示範影片再下筆,依我鬼畫符了幾張的經驗,自然景物的呈現會比建築物或是橋樑之類的來的漂亮跟真實;輸出的解析度固定是512x512;畫完圖之後,可以嘗試按下面的材質參考圖,你的圖就會依照參考圖改變呈現方式,不只有些區塊會替換材質,光影變化也會依參考圖變的更亮或更暗,超酷😍;另一個NVIDIA強調的特點就是,如果你直接更改畫好的圖的某一區塊,其他區塊也會因應改變,例如:把草地改成雪地,樹木就會掛上雪;在水的旁邊擺山,山的倒影就會映在水面上

▼NVIDIA的示範影片

▼畫建築物看起來就怪怪的了

▼同一張圖,不同的材質影響呈現

GauGAN的基底就是透過一組互相對抗的AI,來創造出最後的風景照:一個Generator,以它學習過的數百萬張風景照,來負責產生內容;另一個Discriminator,檢查產生出的內容,是不是跟真實影像相似。GauGAN的由來,是NVIDIA研究單位NVIDIA Research之前的計畫 PIX2PIXHD跟VID2VID,這些都牽涉到AI能不能辨識出圖片、影片裡的各區塊是什麼材質,才能保持原來的元素,並替換到另一個圖片、影片裡。NVIDIA Research研究員劉洺堉就突發奇想,如果這個轉換過程反過來呢?換我們來指定圖中的一塊區域是什麼材質,讓AI來產出影像,最後就產生了我們看到的這個GauGAN計畫啦👍

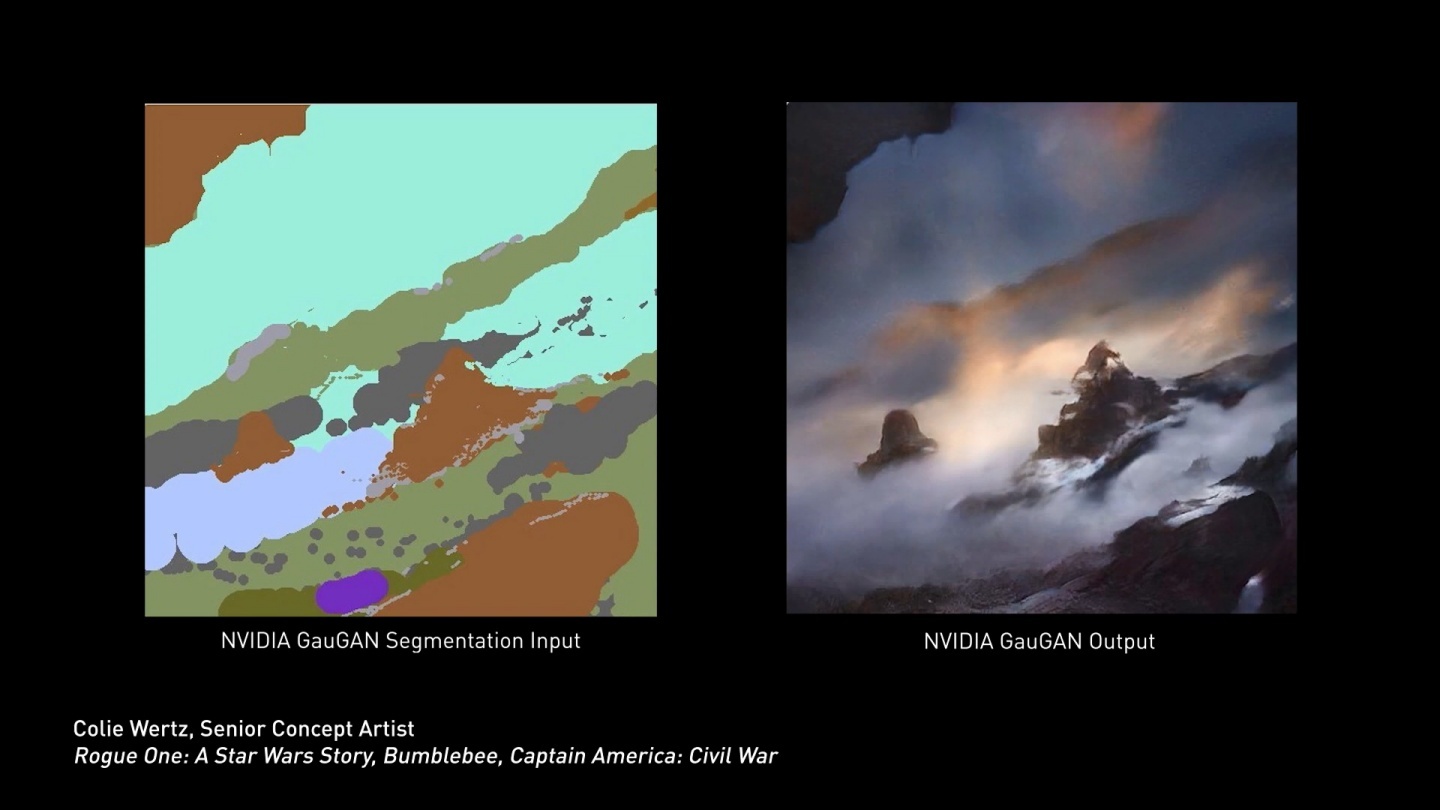

▼看一下藝術家利用GauGAN創造出的美照

(圖片來源:NVIDIA YouTube)

那為什麼要叫做「GauGAN」呢?其實是這個計畫用到的技術「對抗生成網路」英文縮寫就叫GAN,另外也有紀念印象派畫家高更的意思;還有你不覺得用GauGAN創造出來的圖片,很印象派嗎🤣未來GauGAN的目標是能產生高解析度的圖片以及短片,以及征服有關「太陽」的問題,因為太陽對周圍景物產生的光影變化,是AI目前無法解決的。P編覺得這個技術超好玩的,而且很適合讓人快速得到自己腦裡初始構圖,畫出來大概會是什麼模樣;上面兩張貼來給大家笑,歡迎獺友也分享你們的大作哦😳

(新聞來源:NVIDIA)